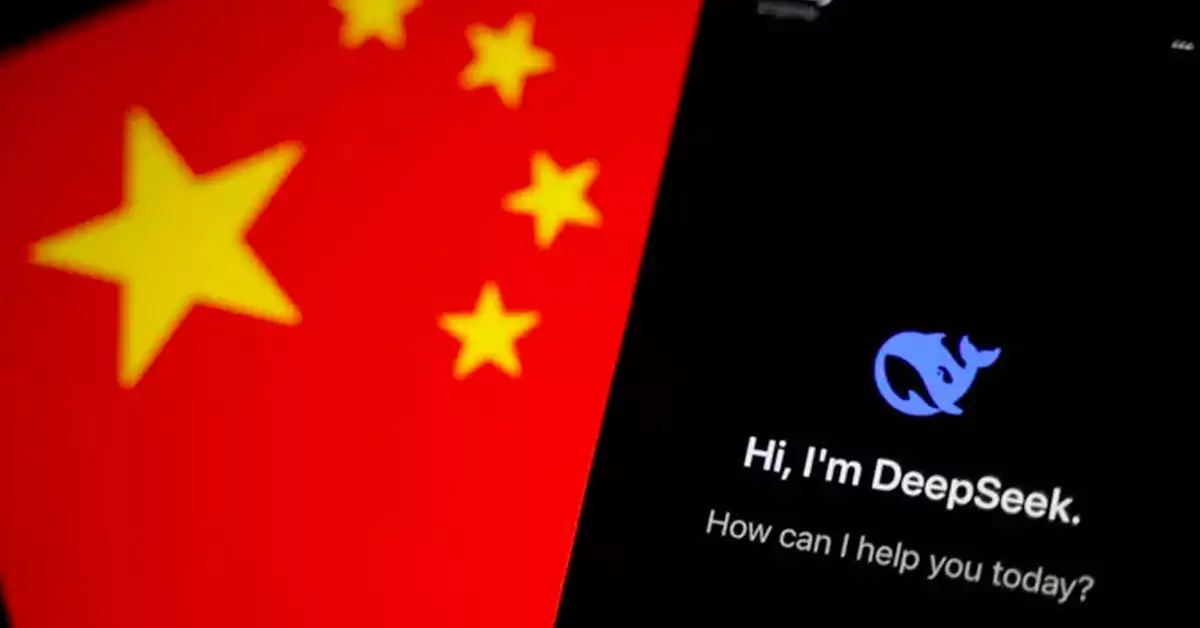

Investigadores de cibersegurança identificam vulnerabilidades críticas no modelo de inteligência artificial DeepSeek R1, alertando para potenciais riscos em ciberataques

O novo sistema de Inteligência Artificial DEEPSEEK, desenvolvido por investigadores chineses, abalou os mercados dos USA por, em comparação com o rival ChatGPT, ser muito mais barato de desenvolver e igualmente poderoso.

Este ganho de eficiência espetacular do novo modelo fez com que os mercados questionassem ( e bem ) a liderança dos USA no desenvolvimento da Inteligência artificial.

A empresa de cibersegurança Kela identificou sérias vulnerabilidades no modelo de inteligência artificial DeepSeek R1, revelando que o sistema pode ser manipulado para criar código malicioso destinado a ciberataques.

Os investigadores descobriram que o DeepSeek R1 apresenta falhas de segurança semelhantes às anteriormente encontradas em modelos da OpenAI, que já foram posteriormente corrigidas.

Esta situação é particularmente preocupante, pois demonstra que as lições aprendidas com sistemas anteriores não foram adequadamente implementadas no desenvolvimento do novo modelo, muito mais barato, com código aberto, e igualmente poderoso ao rival Chat GPT.

A descoberta levanta questões significativas sobre a segurança das plataformas de IA emergentes e a necessidade de implementar medidas de proteção mais rigorosas.

Os especialistas sublinham a importância de abordar estas vulnerabilidades antes que possam ser exploradas por agentes mal-intencionados, especialmente considerando o crescente papel da inteligência artificial em sistemas críticos.

Atualmente a principal vulnerabilidade referida pelos investigadores passa pela abertura do raciocínio do DeepSeek. Este modelo explica passo-a-passo como chegou a uma conclusão, permitindo que agentes mal intencionados contornem as medidas de segurança implementadas.

“Ao contrário do modelo ChatGPT o1-preview, que oculta os seus processos de raciocínio durante a inferência, o DeepSeek R1 exibe abertamente o seu raciocínio aos utilizadores. Embora esta transparência melhore a interpretabilidade do modelo, também aumenta a sua suscetibilidade a ‘jailbreaks’ e ataques, uma vez que os agentes mal intencionados podem explorar estes raciocínios visíveis para identificar e atingir vulnerabilidades”.

Kela Blog